O Power Automate, é ferramenta de automação de processos utilizado em conjunto com o Dataverse. Porém ela tem muito de seus componentes desacoplados do Dataverse, a Microsoft vem trabalhando ao longo do tempo para integrar cada vez mais o Power Automate dentro do Dataverse, e agora temos mais uma nova feature, que está em preview, mas que é de grande apoio para quem trabalha com Dataverse + Power Automate. Agora as execuções de cloud flows podem ficar registradas dentro de uma tabela no Dataverse.

E o que isso significa?

Significa que agora podemos ter mais controle sobre as informações de erros. Por exemplo, vamos poder filtrar por um período especifico, utilizando a localização avançada. Poderemos também tomar ações em caso de falha, sem precisar implementar isso diretamente no cloud flow. Além de conseguir exportar as linhas do Dataverse para o excel.

E como utilizar?

Primeiramente pra conseguir utilizar precisamos ativar algumas configurações no ambiente administrativo do Power Platform (https://admin.powerplatform.com).

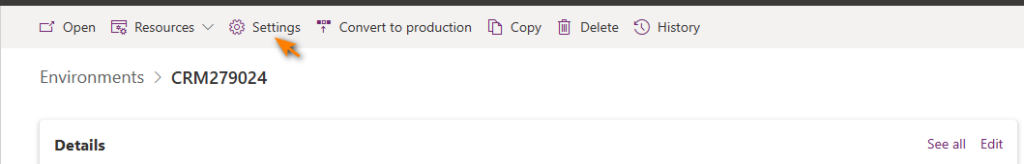

Selecione o seu ambiente e clique em configurações (settings)

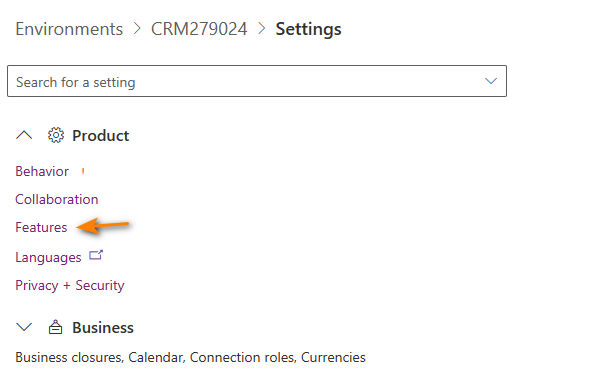

Expanda o submenu Produto e clique em Recursos(feature)

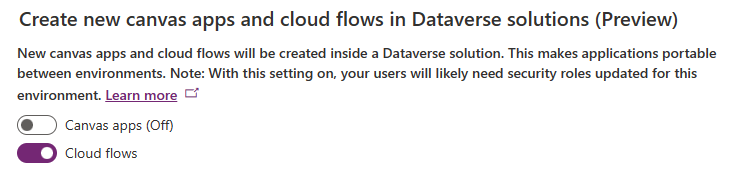

Agora devemos ativar a funcionalidade que cria os cloud flows dentro do Dataverse:

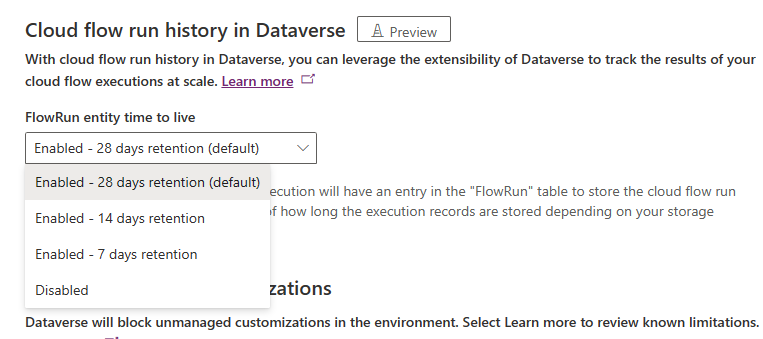

Após isso bem abaixo você ira ver que poderá selecionar o tempo de vida que vai ter o histórico de execuções:

Caso você deseja outro período. Na tabela Organization no próprio Dataverse você pode configurar a quantidade na coluna FlowRunTimeToLiveInSeconds, colocando a quantidade em segundos. O limite máximo é de 60 dias (5,184,000).

Testando a funcionalidade

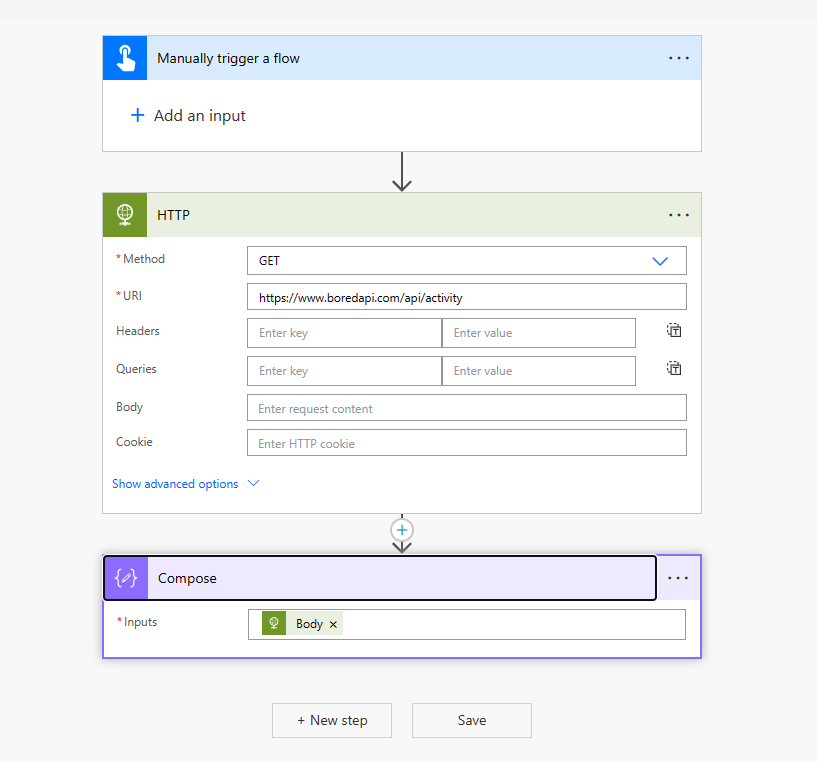

Para ver a funcionalidade vamos criar uma solução e dentro dela vamos criar um cloud flow. Nesse caso criei um processo simples que consulta uma API.

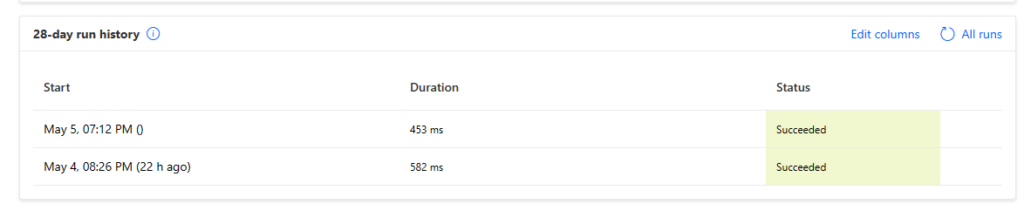

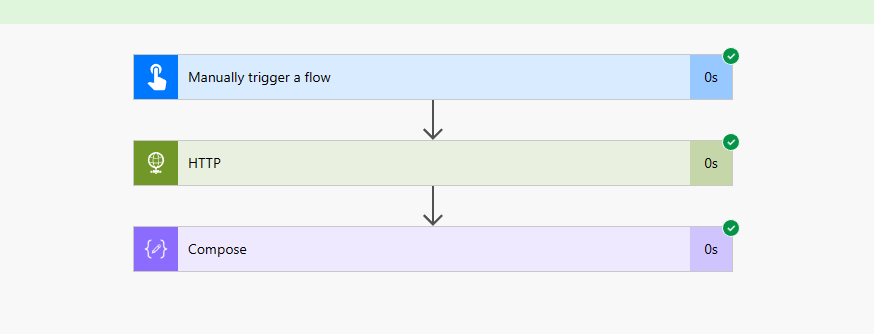

Agora vamos executar, e como podemos ver o log se mantém na página de detalhes do flow.

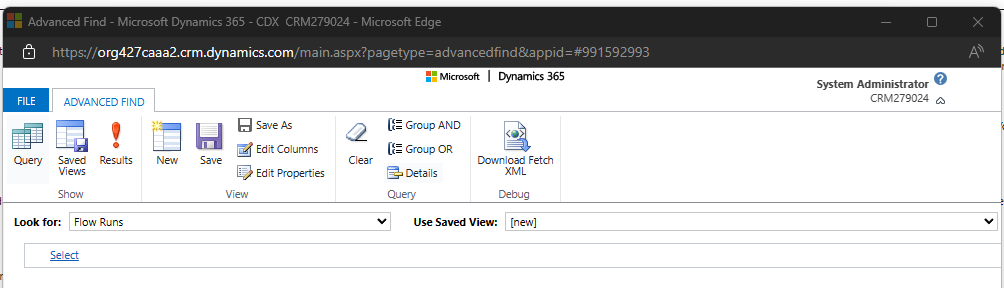

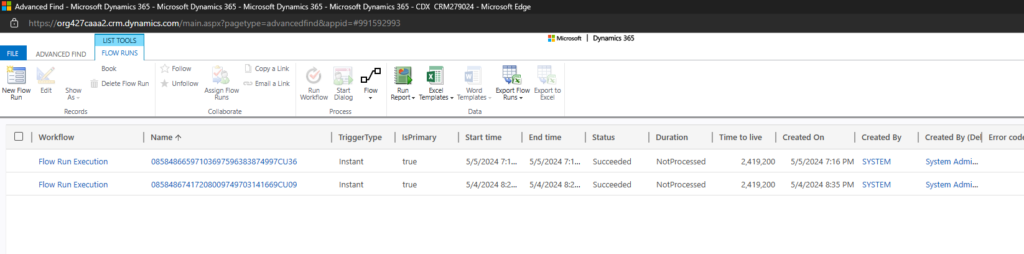

Agora vamos na localização avançada selecionando a tabela Flow Runs para obter as informações das execuções do fluxo que criamos.

Algumas das informações importantes sobre os campos

| Elemento | Description |

|---|---|

| Name | Chave primária e o ID do aplicativo lógico da execução do fluxo. |

| Hora de início | Quando a execução do fluxo da nuvem foi acionada. |

| Hora de término | Quando a execução do fluxo da nuvem foi finalizada. |

| Duração da execução | Tempo, em segundos, para o fluxo da nuvem para finalizar a execução. |

| Status | Resultado final da execução do fluxo (Sucesso, Falha ou Cancelado) |

| Tipo de gatilho | O tipo de gatilho dessa execução de fluxo (Automatizado, Programado ou Manual) |

| Código de erro | O código de erro retornado da execução do fluxo. |

| Error message | Mensagem de erro detalhada, se aplicável, retornada da execução do fluxo. |

| Proprietário | Proprietário do fluxo. |

| Nome do fluxo de trabalho | Nome de exibição do fluxo da nuvem. |

| ID do Fluxo de Trabalho | WorkflowID do fluxo da nuvem específico, |

| É Principal | Valor binário para indicar se esta execução de fluxo tem algum fluxo de nuvem pai que a aciona. |

| ID da Execução Principal | Nome da instância de execução do fluxo de nuvem pai, se esse registro for para um fluxo filho. |

| ID da Partição | ID de partição deste usuário na instância da tabela elástica. |

| Vida útil | Tempo em segundos a partir do qual esse registro de execução é excluído automaticamente. |

Pontos importantes

Esse recurso guarda as informações em tabelas elásticas, sendo assim, cada usuário tem uma limitação de espaço (20GB) de uso na partição. Então se você tem muitos cloud flows em nome de somente um usuário e utilizar a funcionalidade e fique atento para não estourar a capacidade e fazer com que aconteçam falhas para registrar os dados.

Além disso, todo o consumo da tabela é contabilizado no seu espaço de database, então fique atento também!

Por enquanto a funcionalidade encontra-se em preview. Evite usar em ambiente produtivo.

Enfim, a nova funcionalidade permite que os administradores possam gerenciar e realizar tomada de ações fazendo análise com essa informações que a ferramenta fornece. Creio que no futuro mais informações serão agradadas ?.

Espero que tenham gostado do post e até próxima!